【DeepSeek简介】

近段时间,你耳边听到的,除了“过年”以外,还有一个火遍全球的词,没错了,就是“DeepSeek”!

DeepSeek是杭州深度求索人工智能基础技术研究有限公司(成立于2023年7月17日)研发的推理模型,该模型采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务。2025年1月20日,DeepSeek正式发布 DeepSeek-R1 模型,并同步开源模型权重。DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。2025年1月27日,DeepSeek应用登顶苹果美国地区应用商店免费APP下载排行榜,在美区下载榜上超越了ChatGPT。同日,苹果中国区应用商店免费榜显示,DeepSeek成为中国区第一。

【Ollama简介】

Ollama是一个专为在本地环境中运行和定制大型语言模型而设计的工具。它提供了一个简单而高效的接口,用于创建、运行和管理这些模型,同时还提供了一个丰富的预构建模型库,可以轻松集成到各种应用程序中。Ollama的目标是使大型语言模型的部署和交互变得简单,无论是对于开发者还是对于终端用户。

【open-webui简介】

open-webui 是一款可扩展的、功能丰富的用户友好型自托管 Web 界面,旨在完全离线运行。它支持包括 Ollama 和与 OpenAI 兼容的 API 在内的多种 LLM 运行器。

【温馨提醒】

➤这玩意在本地部署的话,比较吃CPU、内存和显存等硬件资源(具体要求请阅读本教程末尾的“DeepSeek-R1各版本的使用说明和硬件要求”)。如果你的NAS没有英伟达的独立显卡,只能装1.5b的模型玩玩,否则会卡到你怀疑人生;

➤如果你的硬件配置不佳,也可以去白嫖腾讯云8核心CPU+32G内存+NVIDIA Tesla T4 16G显存的Ollama服务器搭建DeepSeek-R1大语言模型,具体操作请阅读【此教程】。

【群晖NAS本地部署教程】

1、打开群晖的套件中心,先安装好Container Manager;

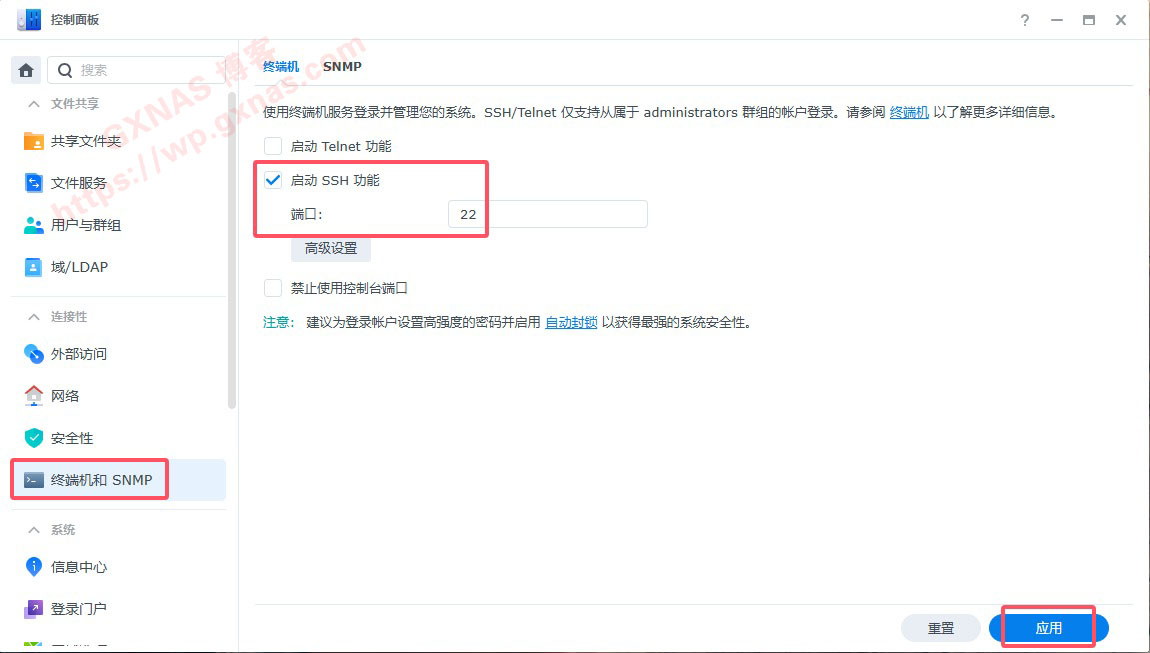

2、打开群晖控制面板,终端机和SNMP,在“启动SSH功能”处打勾,并设置好端口号,应用;

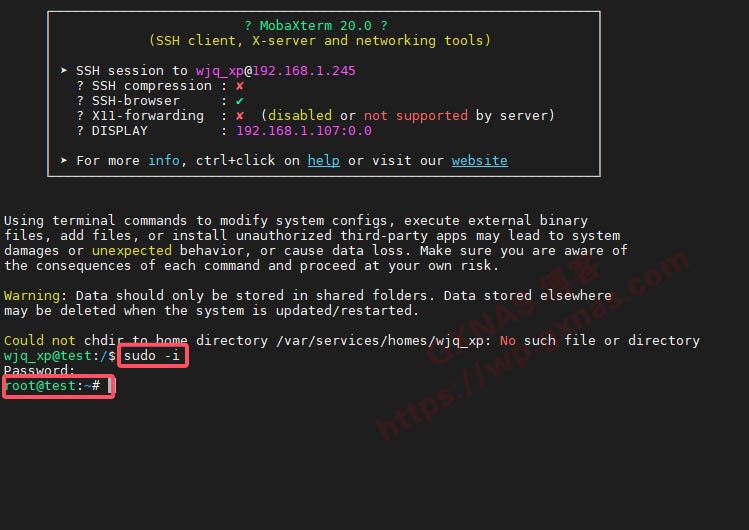

3、在电脑上打开SSH工具(本教程使用MobaXterm),填写群晖的IP地址,SSH端口,群晖管理员账号,输入管理员密码登录;

4、输入 sudo -i 回车,再次输入管理员密码回车,进入root状态下;

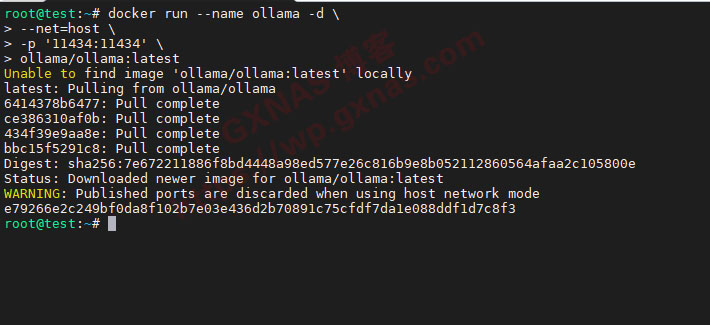

5、根据自己的机器有无GPU,复制对应的脚本(第4行的/volume1/docker/ollama是AI模型的下载路径,请根据自己实际路径填写)到ssh下运行,如果运行后报错Error Get "https://registry-1.docker.io/v2"的,请参考《本教程》设置docker加速镜像);

无GPU的脚本:

docker run --name ollama -d \

--restart always \

--net=host \

-v /volume1/docker/ollama:/root/.ollama \

ollama/ollama:latest有GPU的脚本:

docker run --name ollama -d \

--restart always \

--net=host \

-v /volume1/docker/ollama:/root/.ollama \

--privileged=true \

--gpus=all \

ollama/ollama:latest

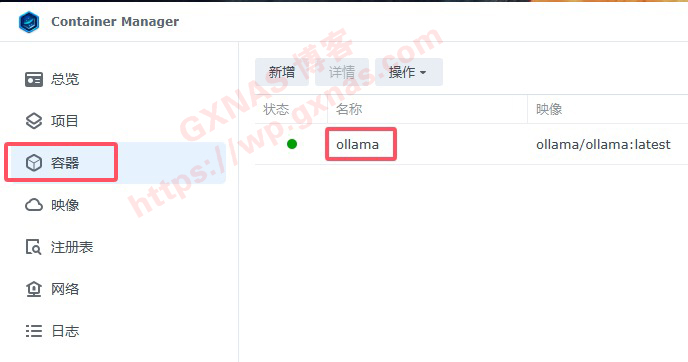

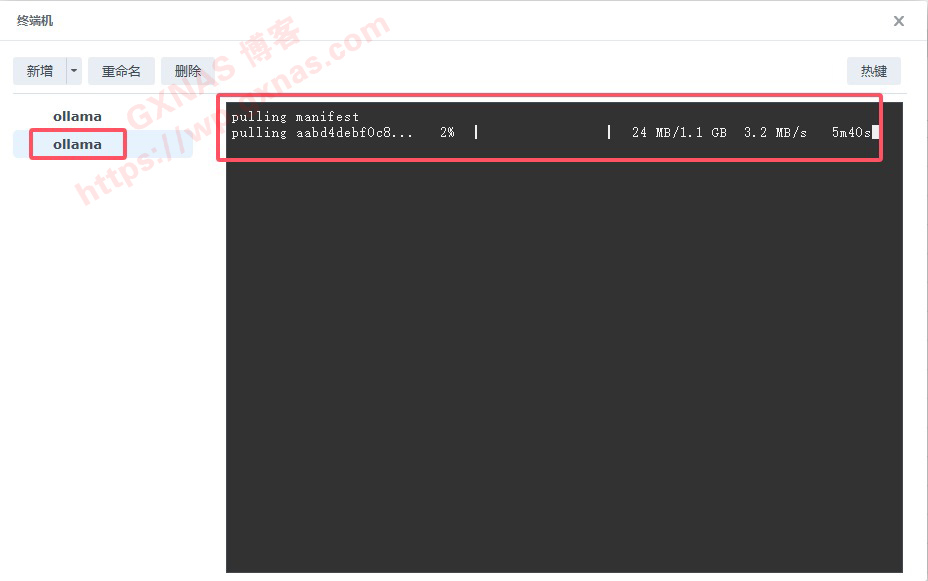

6、返回群晖Container Manager,容器,看到ollama容器已经在运行中,点击ollama;

9、根据自己实际情况选择安装的模型(每个模型的使用说明和硬件要求看本教程文末),本教程安装的是1.5B的模型,如果你想安装别的模型,可以把命令中的1.5b换成你想安装的模型名称(字母用小写);

ollama run deepseek-r1:1.5b

11、当看到有显示 success 的时候,表示该模型已经安装成功,此时可以用命令行来使用了,但是这样操作不方便,我们还需要装一个图形界面;

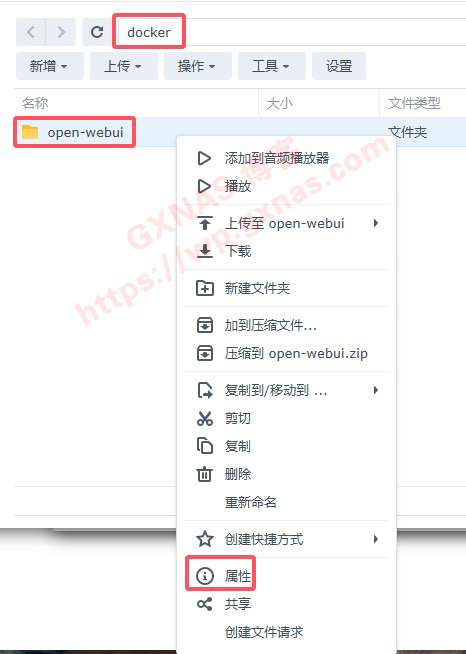

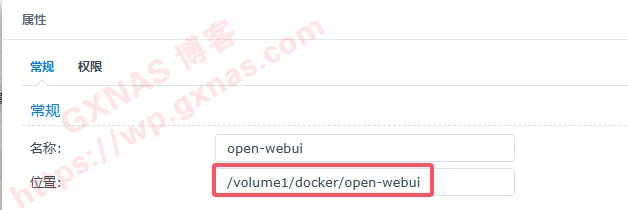

12、打开群晖file station,在非中文、没有特殊符号的文件夹中,建立一个名称为open-webui的子文件夹,在open-webui的文件夹点右键,属性;

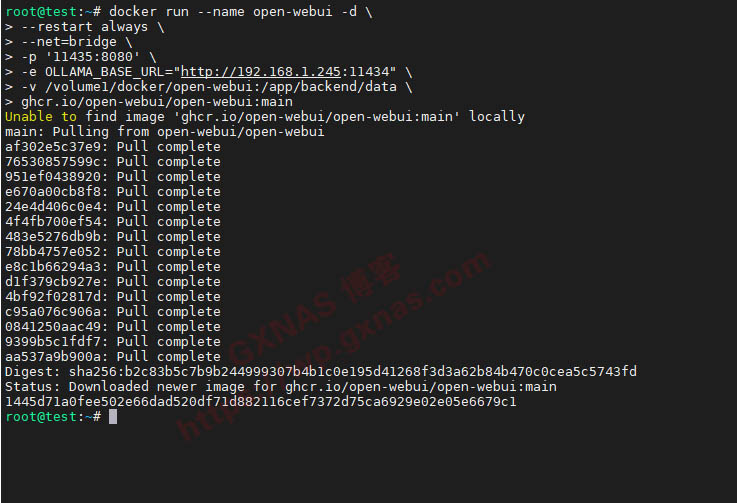

14、复制以下命令到记事本中,把命令中的192.168.1.245改成你的群晖IP地址,把命令中的/volume1/docker/open-webui改成上一步骤复制的路径,安装open-webui;

docker run --name open-webui -d \

--restart always \

--net=bridge \

-p '11435:8080' \

-e OLLAMA_BASE_URL="http://192.168.1.245:11434" \

-v /volume1/docker/open-webui:/app/backend/data \

ghcr.io/open-webui/open-webui:main

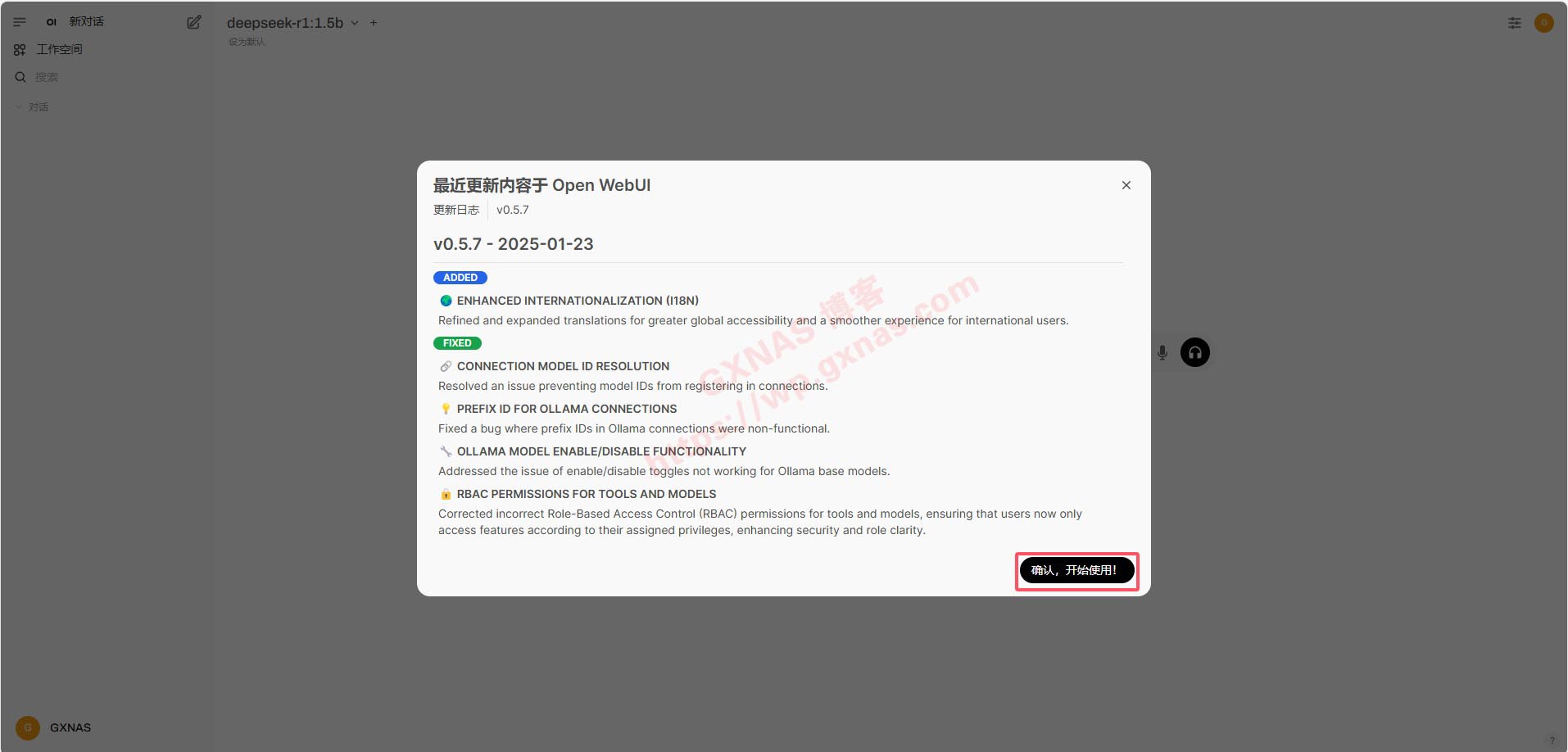

15、在浏览器打开http://群晖的IP:11435,点开始使用(如果还没显示的话可能是容器还没启动好,耐心等待一会再打开);

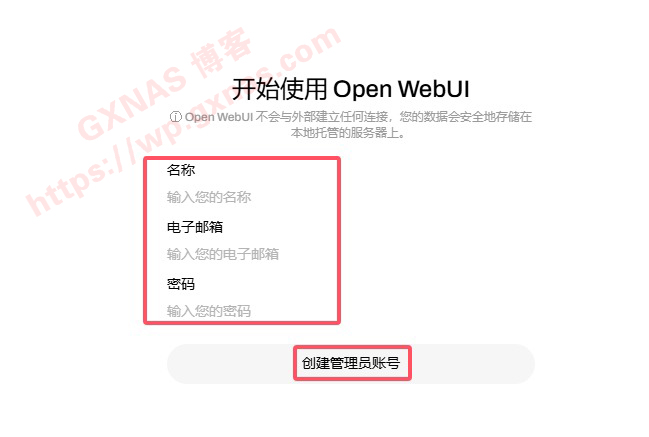

16、输入名称、邮箱、密码,设置登录open-webui的管理员账号;

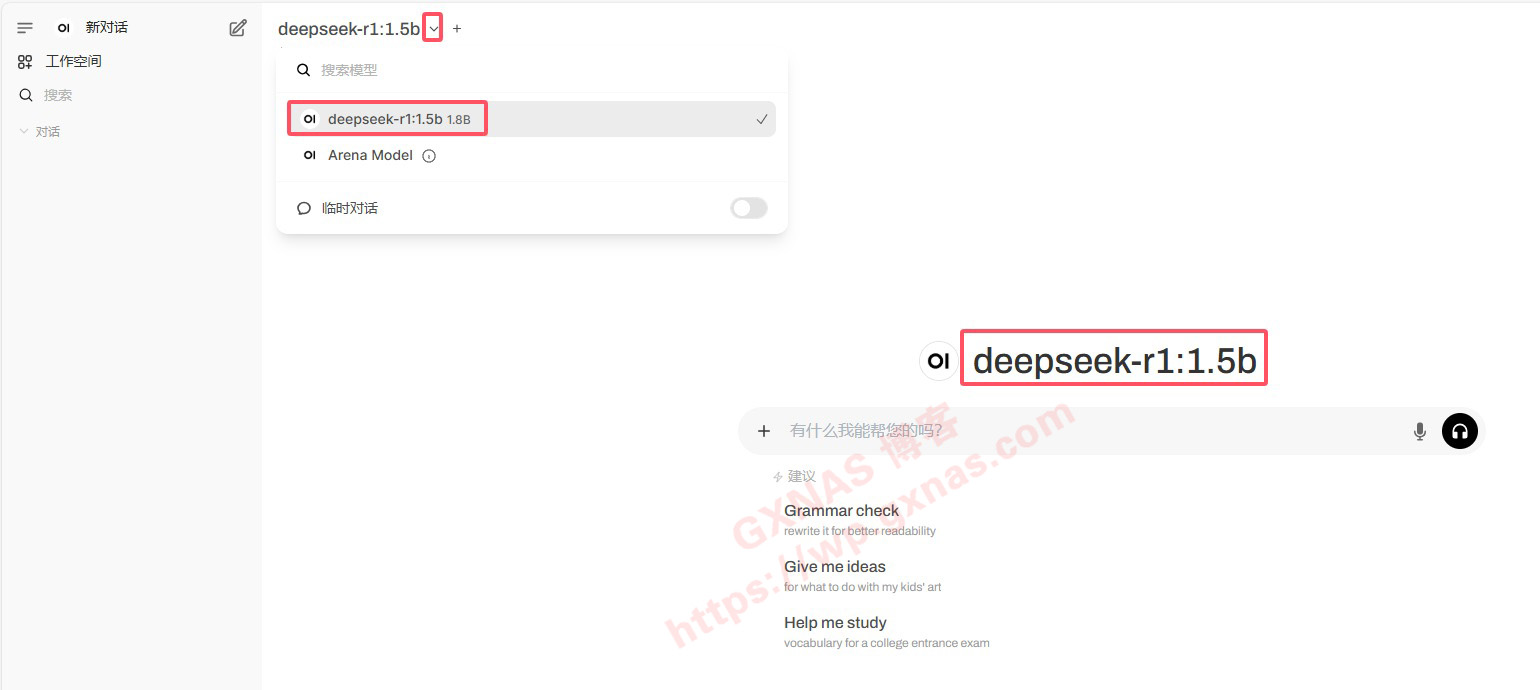

18、由于本教程只安装了deepseek-r1:1.5b,默认就是deepseek-r1:1.5b,如果你装有多个模型的,点下拉列表可以切换模型;

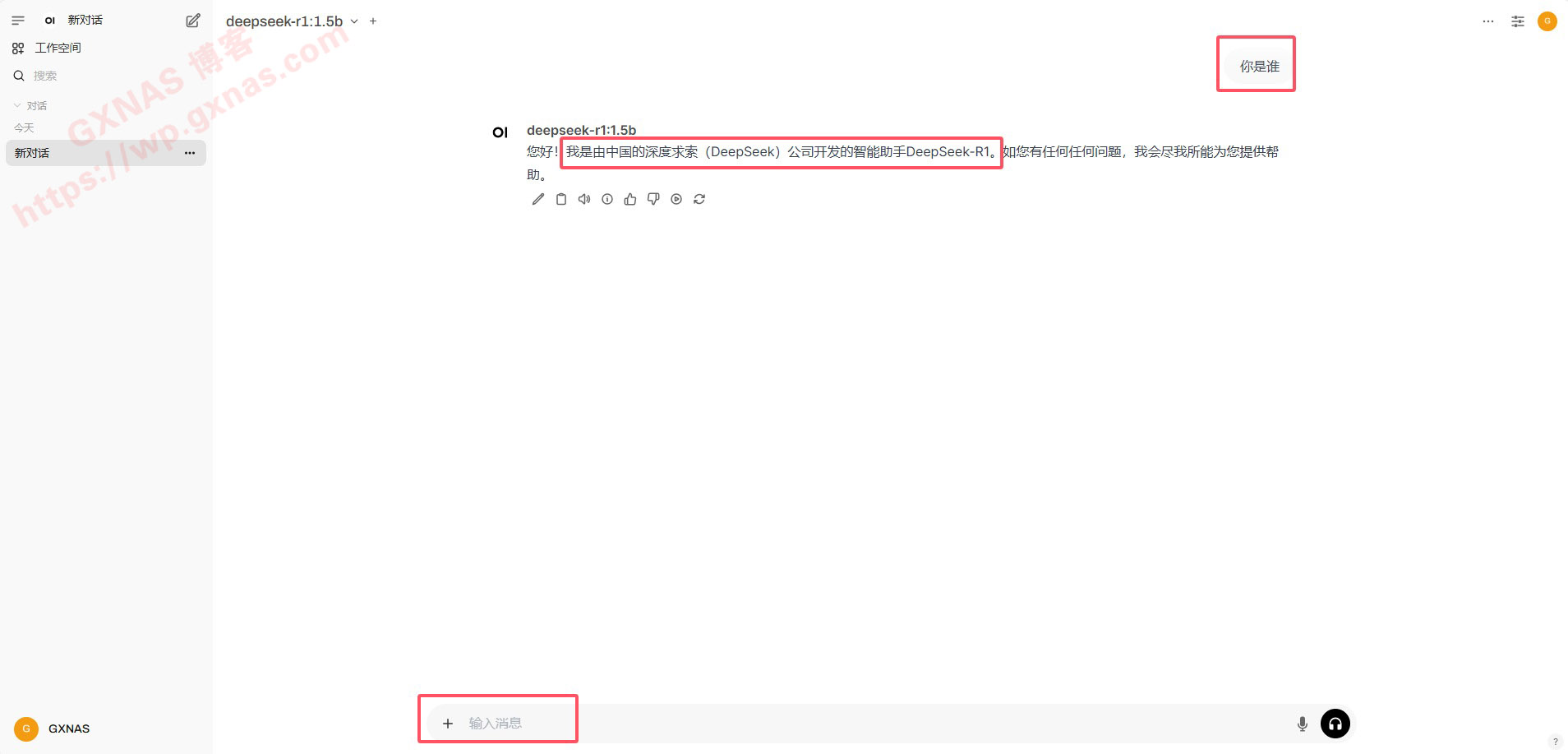

19、测试一下,可以正常使用(由于春节期间deepseek受到美国黑客的攻击,也有可能会遇到有时访问不太正常的,那就另外换个时间再打开吧);

20、如果不喜欢用网页,也可以安装客户端,推荐使用:

(1)Chatbox:支持Windows、MacOS、Android、iOS、Linux,官方下载地址是:https://chatboxai.app/zh

(2)Cherry StudioPortable:同样兼容 Windows、Mac 和 Linux 系统,官方下载地址是:https://github.com/CherryHQ/cherry-studio/releases

【Docker compose方式安装的脚本】

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

restart: always

network_mode: host

volumes:

- /volume1/docker/ollama:/root/.ollama #把/volume1/docker/ollama换成你的实际路径

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

restart: always

networks:

- bridge

ports:

- '11435:8080'

environment:

- OLLAMA_BASE_URL=http://192.168.1.245:11434 #把192.168.1.245换成你的群晖IP地址

volumes:

- /volume1/docker/open-webui:/app/backend/data #把/volume1/docker/open-webui换成你的实际路径

networks:

bridge:

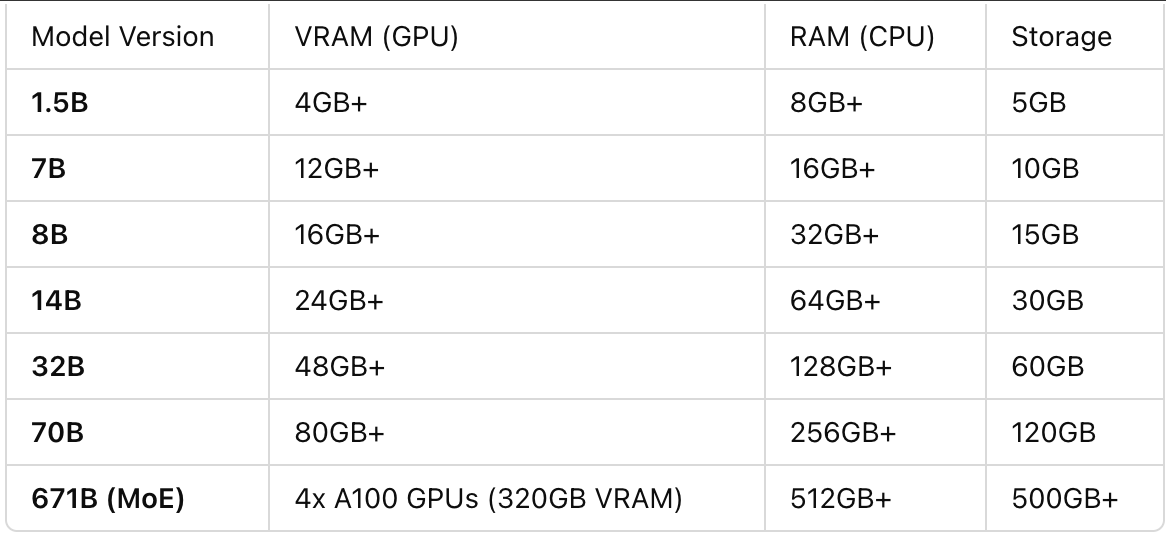

driver: bridge【DeepSeek-R1各版本的使用说明和硬件要求】 ❤1.5B — 针对边缘设备上的快速推理进行优化的轻量级版本。 ❤7B — 适用于通用推理任务的平衡模型。 ❤8B — 更高的准确性和更好的上下文理解。 ❤14B — 推理和解决问题的能力得到提高。 ❤32B — 更强的逻辑分析和更精细的逐步输出。 ❤70B — 适用于高级人工智能驱动应用程序的高端版本。 ❤671B — 专家混合 (MoE) 模型,每个令牌激活 370 亿个参数,以实现最先进的推理性能。

文章评论

现在在研究怎么调用P4独显,研究了几天GPU还是0%。

@aiexonline 盲猜是Ollama容器没得到root权限

遇到了一个小问题,按照大佬你的方法我顺利完成了部署,但是发现deepseek在思考计算时始终没有调用到独显,cpu占用很高,我的显卡是正常用的,docker里的jellyfin是可以调用解码的,请问是否有办法解决?只用cpu的话只能满足1.5B模型

@DrT 如果使用独显,安装ollama命令是另外一个,具体可以去看ollama的教程:https://hub.docker.com/r/ollama/ollama/

@DrT 我也在研究,你研究好了分享一下,哈哈!

每次在ollama终端机拉取,下载老失败是为什么?

@NEWBEE 你可以换个时间段再下载试试

楼主您好,按照您的步骤操作,一路顺畅,但是打开页面时,提示选择一个模型,点开还有没有看到任何模型,是哪里没操作好?

@华城过客 信息量太少,没法判断。不知道你是哪个步骤没做对,建议把容器删了重新做吧。

博主我是I5-8400装的群晖,核显hd630,能玩这个吗

@海蓝色 核显只能玩1.5b,其他模型需要英伟达的独显,模型越大,消耗的内存和显存越多。

按上述方法open-webui找不到模型

@社会主义接班人 应该是你哪里没做对吧

@博主 按上述方法 没漏。。。然后进open-webui无模型。。。

@博主 找到问题了

-e OLLAMA_BASE_URL="192.168.1.245:11434" \问题在这句里面

ip前面要加http://

@社会主义接班人 好的

@社会主义接班人 我的加了http,但是登录后也没找见模型。

@华城过客 我也是,这个问题有什么解决方法吗

@华城过客 我开始也是,后来发现都设置为network_mode: host,就看到模型了,这样只能使用8080端口访问open-webui

博主我想问下,ollama镜像可以直接在Container Manager注册表拉取不?

@社会主义接班人 如果你的NAS有科学环境,Container Manager注册表能正常显示出来的,可以在注册表拉取。

@博主 :zhenbang: