昨天博主写了一篇《在群晖NAS上本地化部署DeepSeek-R1大语言模型的教程》,很多人被硬件要求吓退了,于是博主今天带大家来白嫖腾讯云Cloud Studio(云端 IDE)的Ollama服务器,这样你不需要自己购买昂贵的英伟达显卡,也可以搭建自己专属的DeepSeek-R1大语言模型。

1、在电脑浏览器打开【腾讯云Cloud Studio官网】(Cloud Studio的产品说明在本教程文末),用微信扫码登录后,找到全部模版中的“Ollama”(腾讯云在2025年2月2日上线了DeepSeek-R1模版,但默认是1.5b和7b的模型,想使用别的模型还是同样需要自己安装,所以建议装Ollama吧,Ollama还可以支持多种AI模型),点进去;

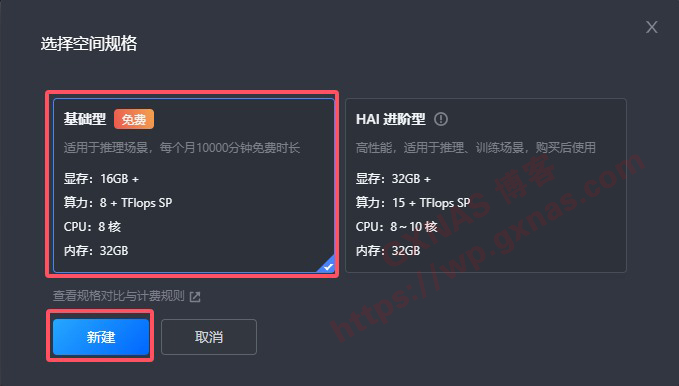

2、选择“基础型”(Cloud Studio的收费说明在本教程文末)新建;

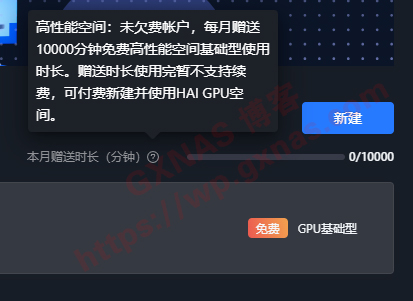

4、免费的GPU基础型服务器,每月1日给予10000分钟的免费使用时长,足够一般人使用了;

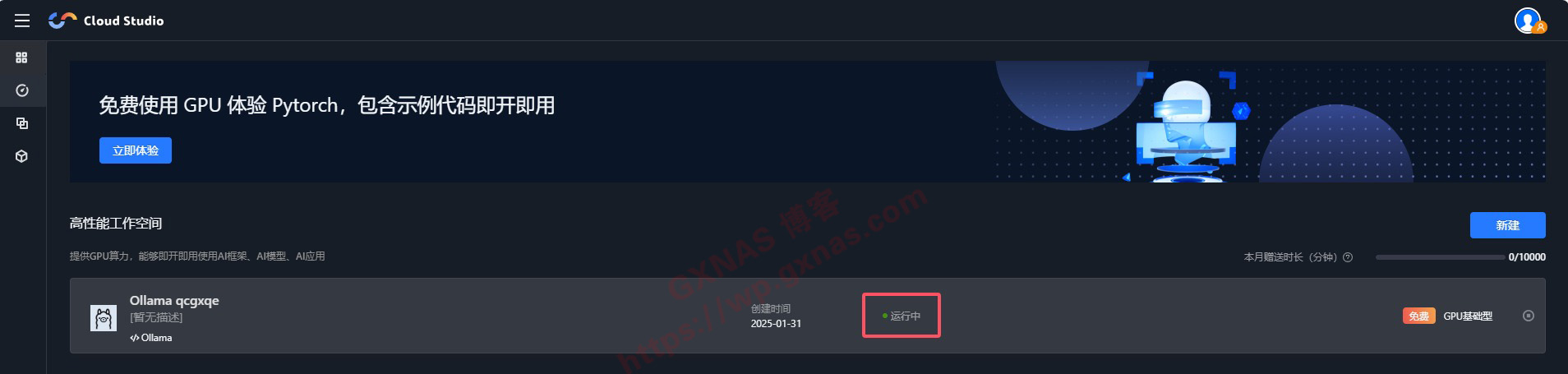

5、等显示为运行中的时候,点进去(如果提示失效的话,删除重新建立);

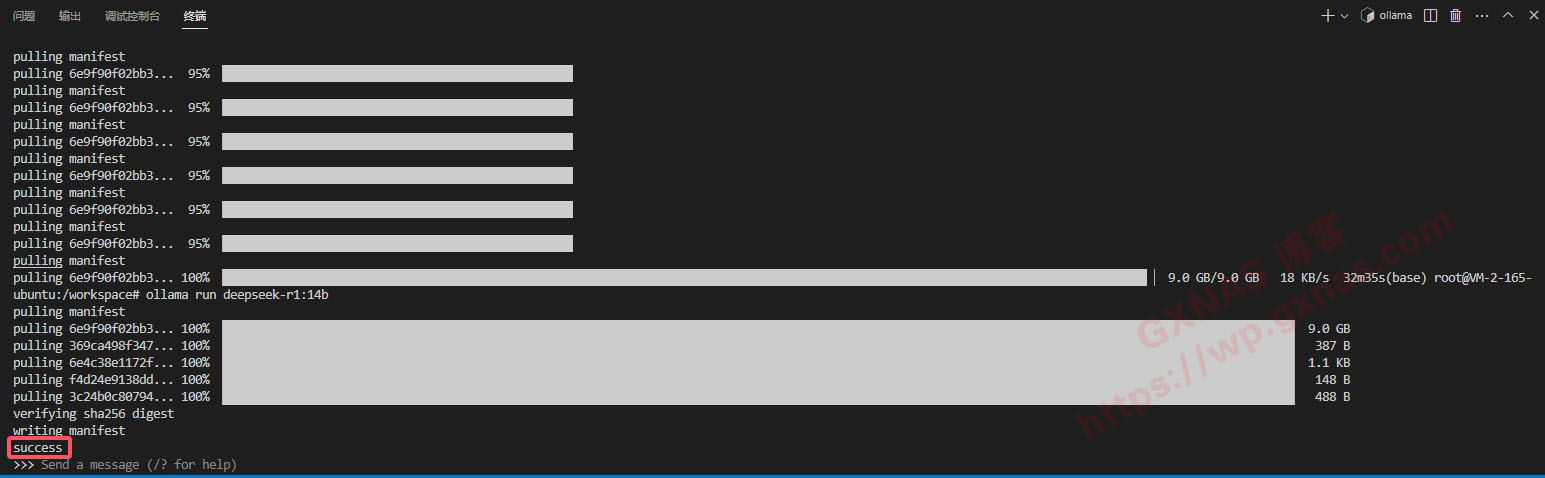

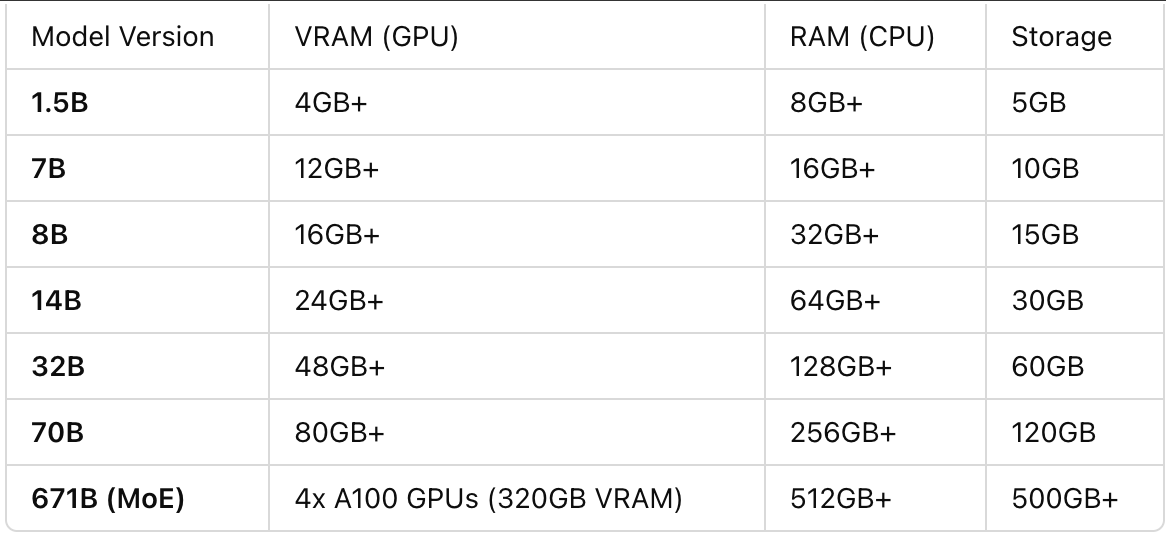

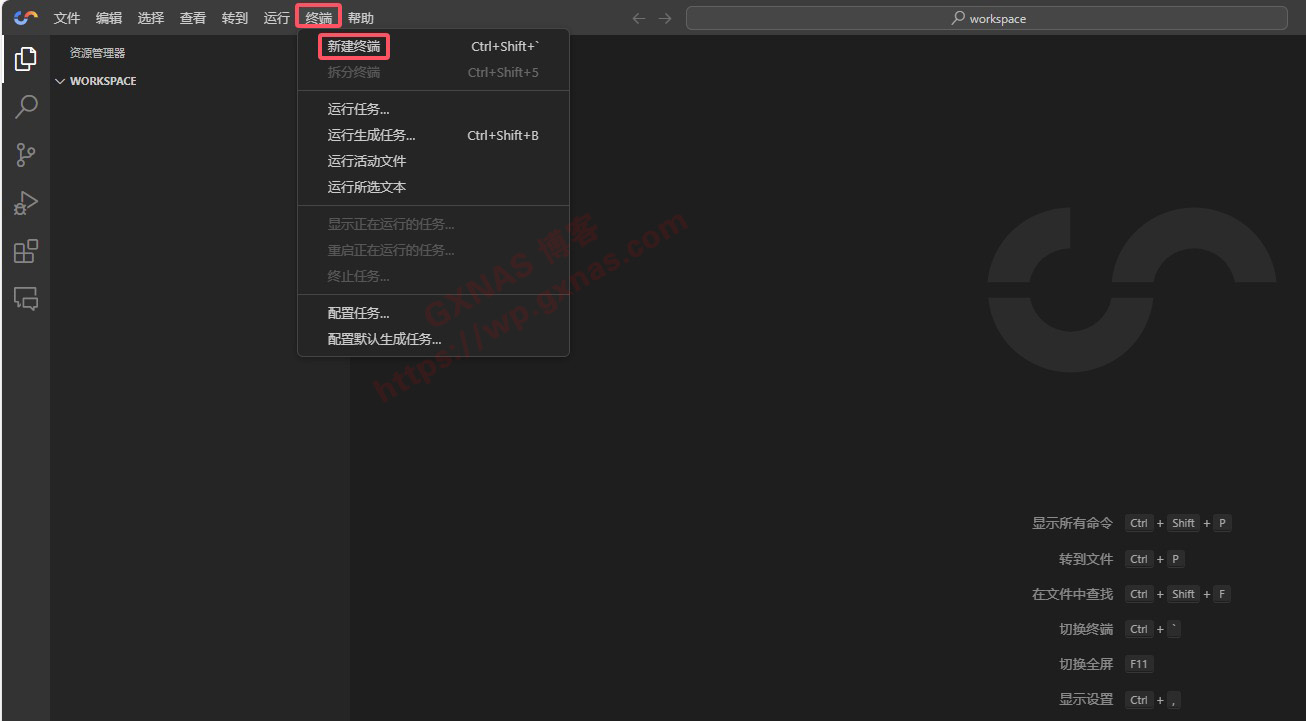

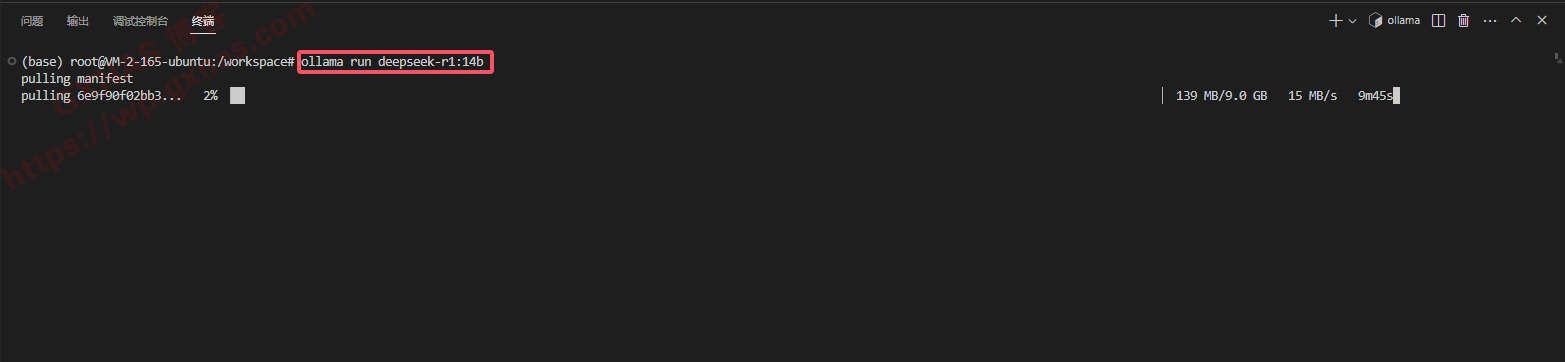

8、根据自己实际情况选择安装的模型(每个模型的使用说明和硬件要求看本教程文末),复制以下命令到终端运行,本教程安装的是14B的模型,如果你想安装别的模型,可以把命令中的14b换成你想安装的模型名称(字母用小写);

ollama run deepseek-r1:14b

9、请耐心等待,博主安装的14b模型下载等待了32分钟,当看到有显示 success 的时候,表示该模型已经安装成功;

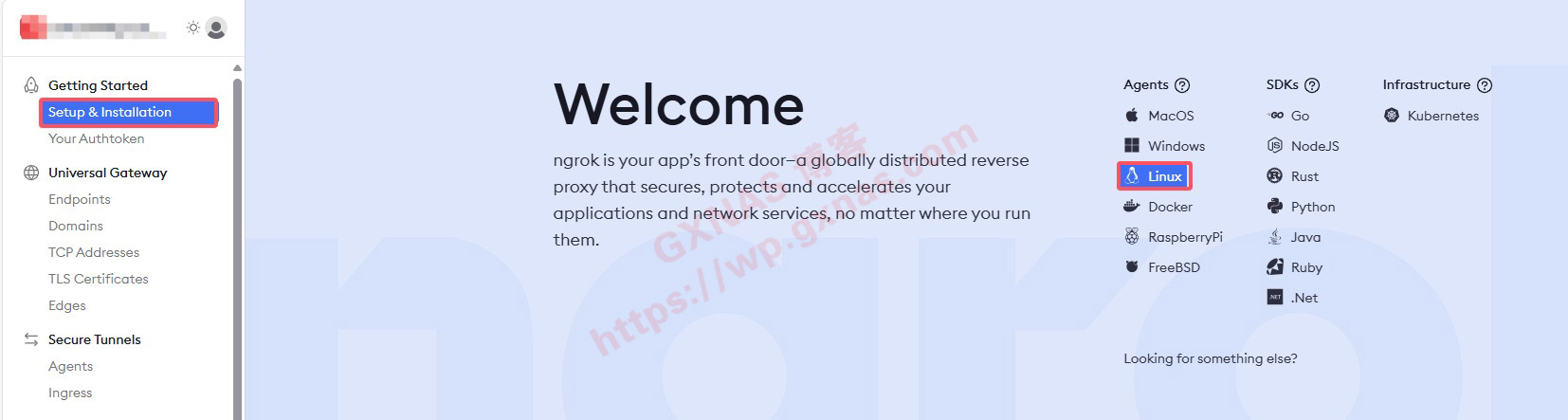

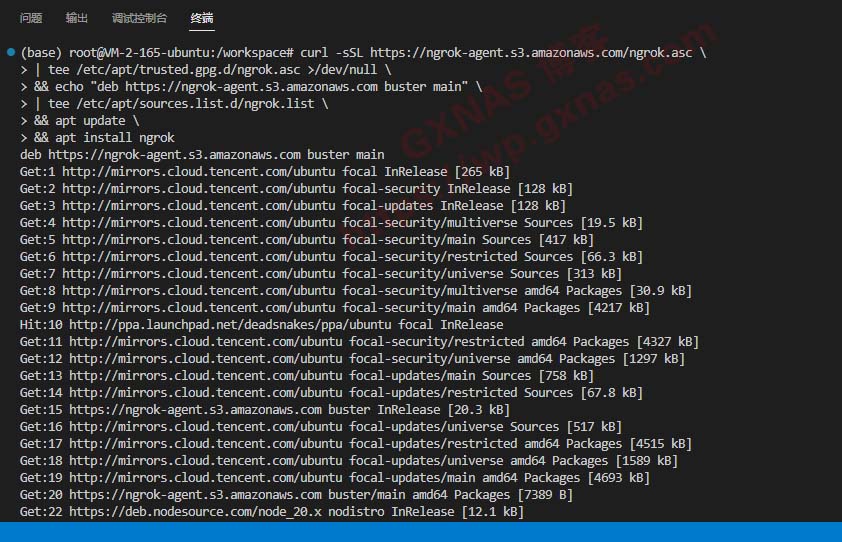

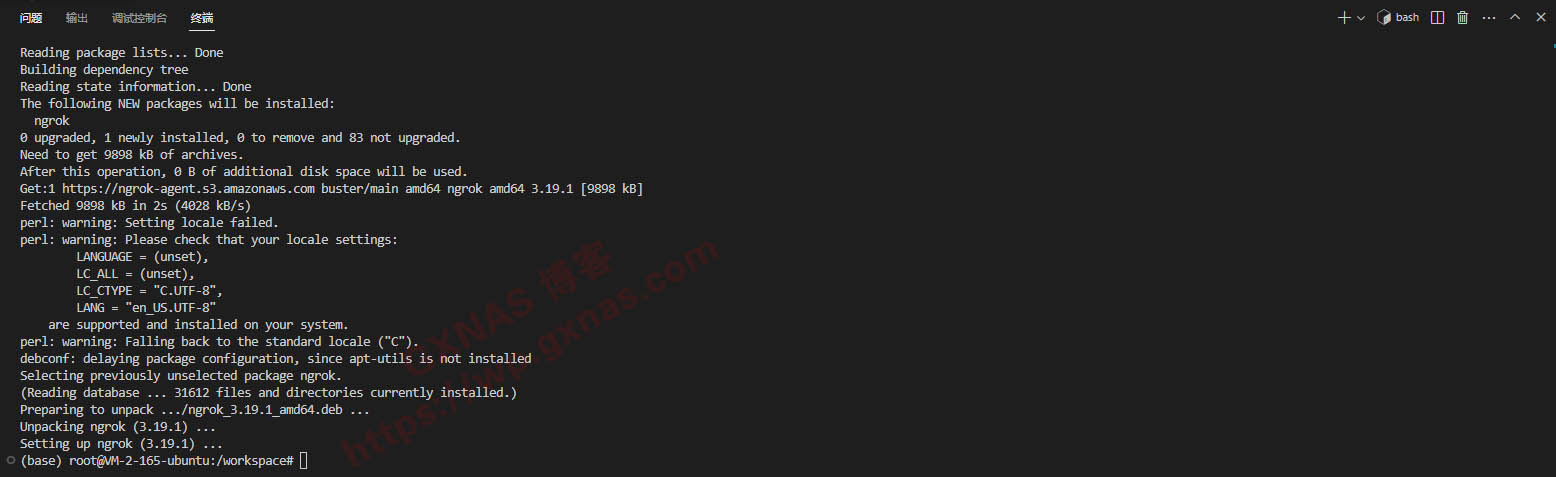

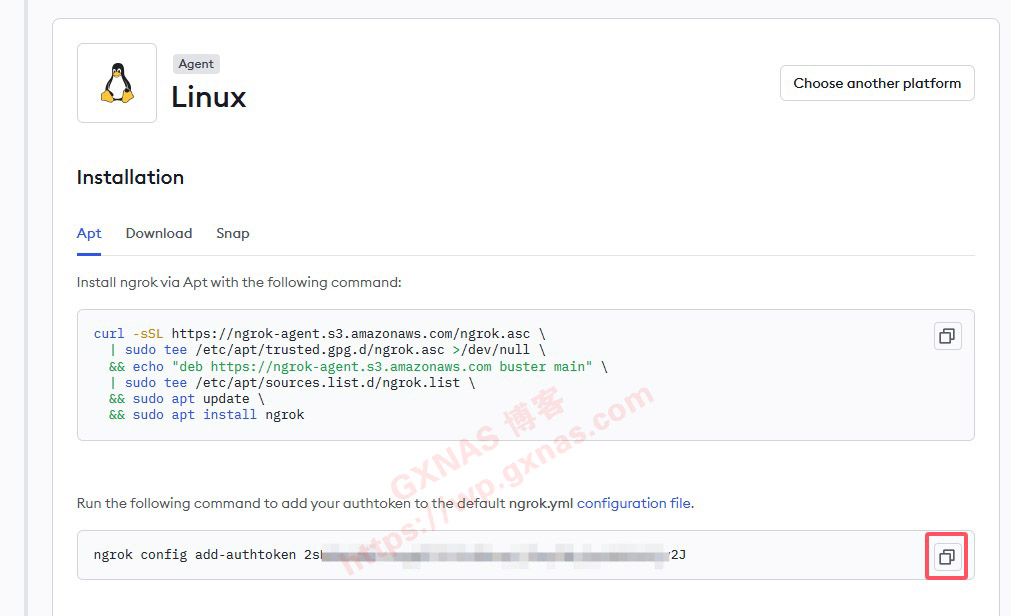

11、由于Cloud Studio默认的提供的网页命令行模式操作不方便,并且也没有外网远程访问的地址,我们还需要装一个图形界面,打开【NGROK官网】,登录你的账号(如果还没注册的请自行注册),点“Setup & Installation”,再点“Linux”;

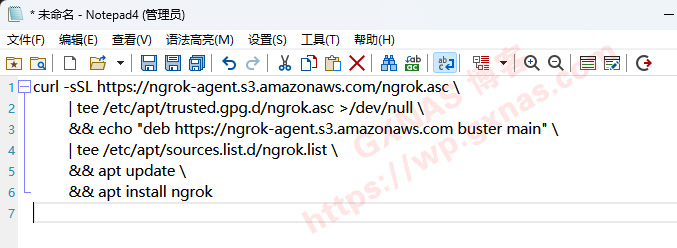

13、粘贴到记事本,然后删除所有的 sudo ,然后再重新复制修改后的脚本;

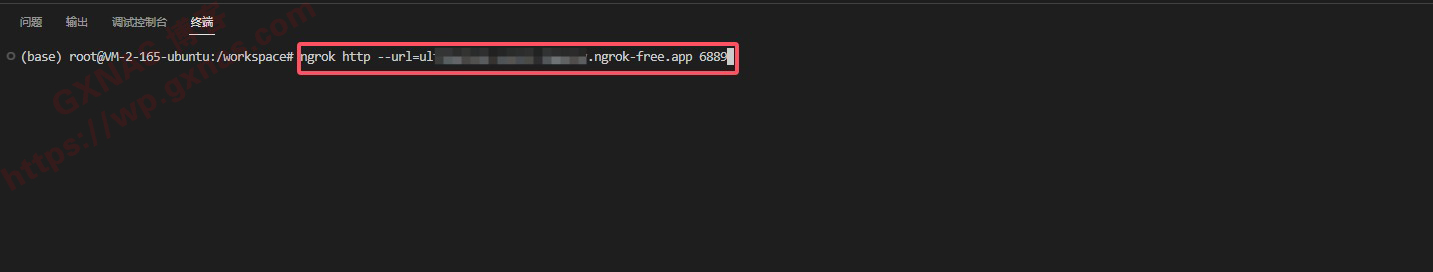

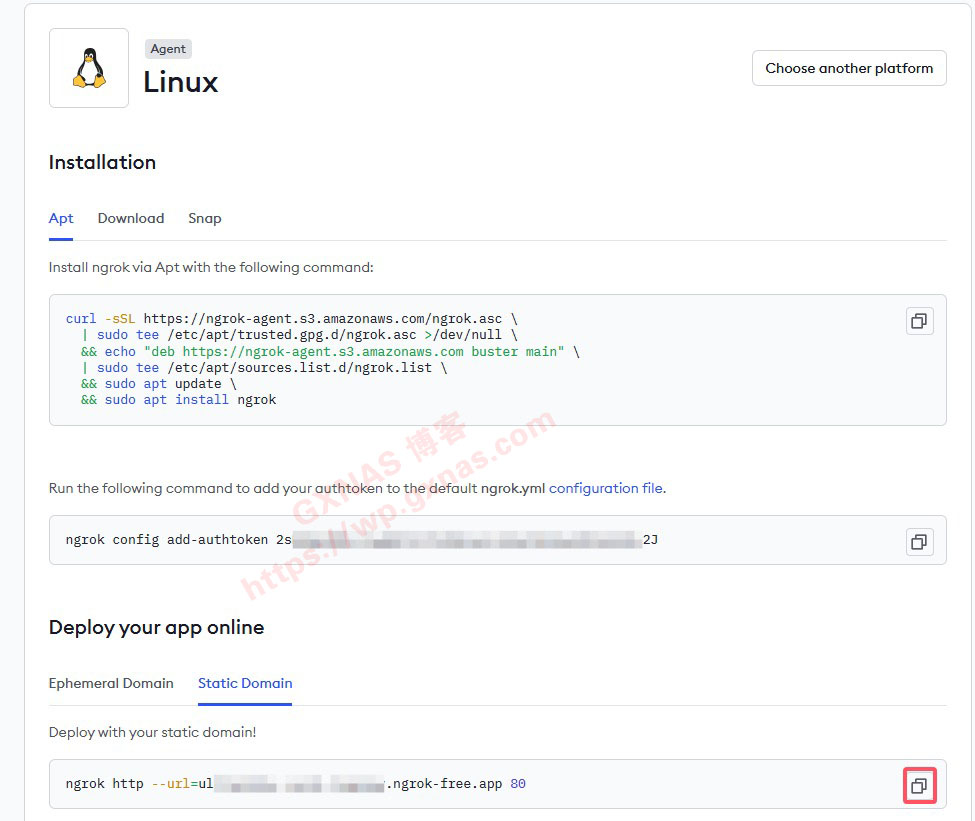

19、粘贴到Cloud Studio终端,先不要运行,把命令最末端的80改成6889,修改好以后按回车运行;

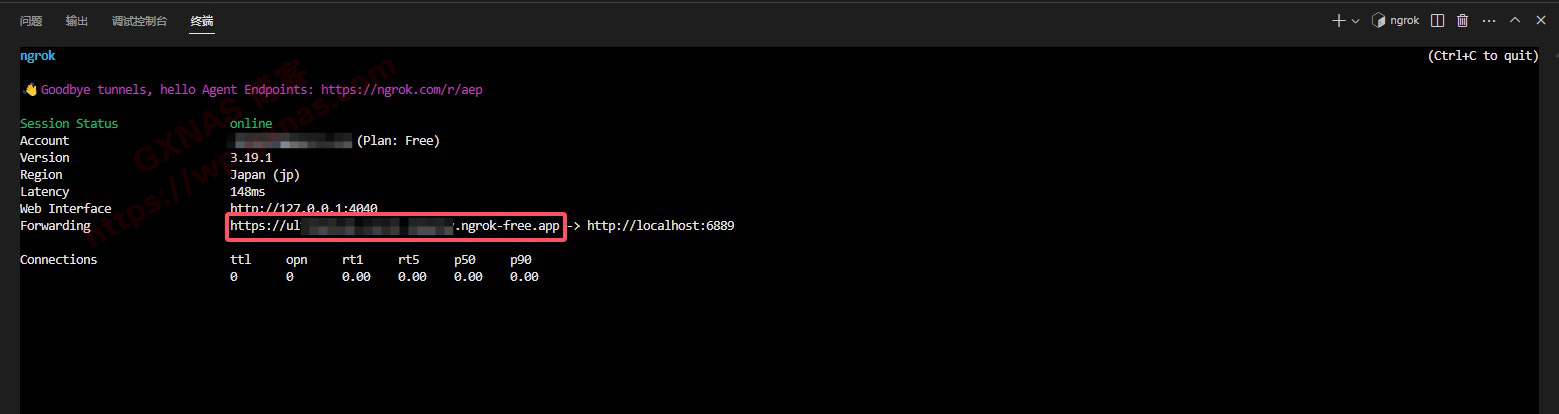

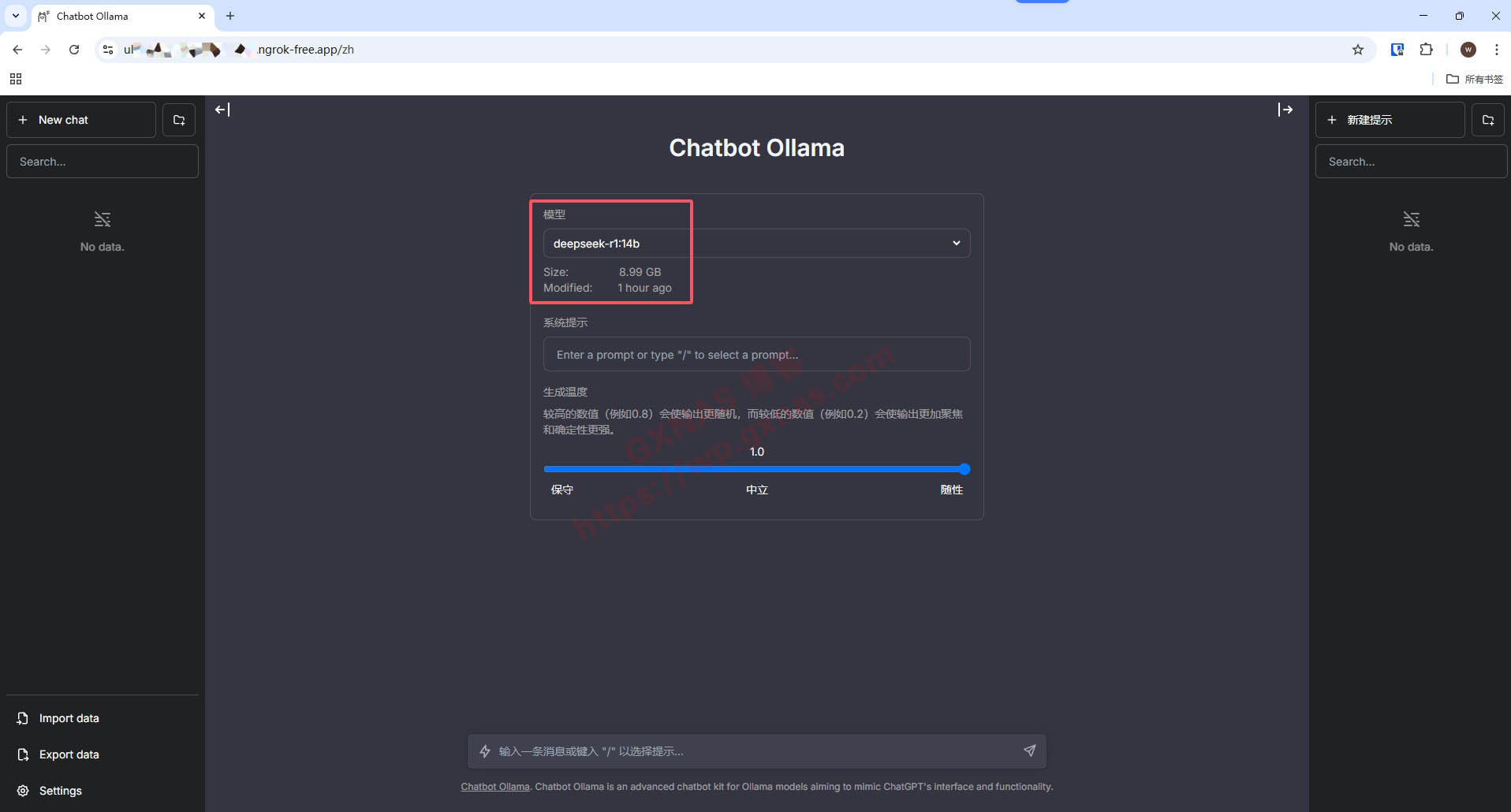

20、运行后的界面如下,https://开头的这个链接,就是我们远程访问DeepSeek-R1的地址,把这个地址复制出来;

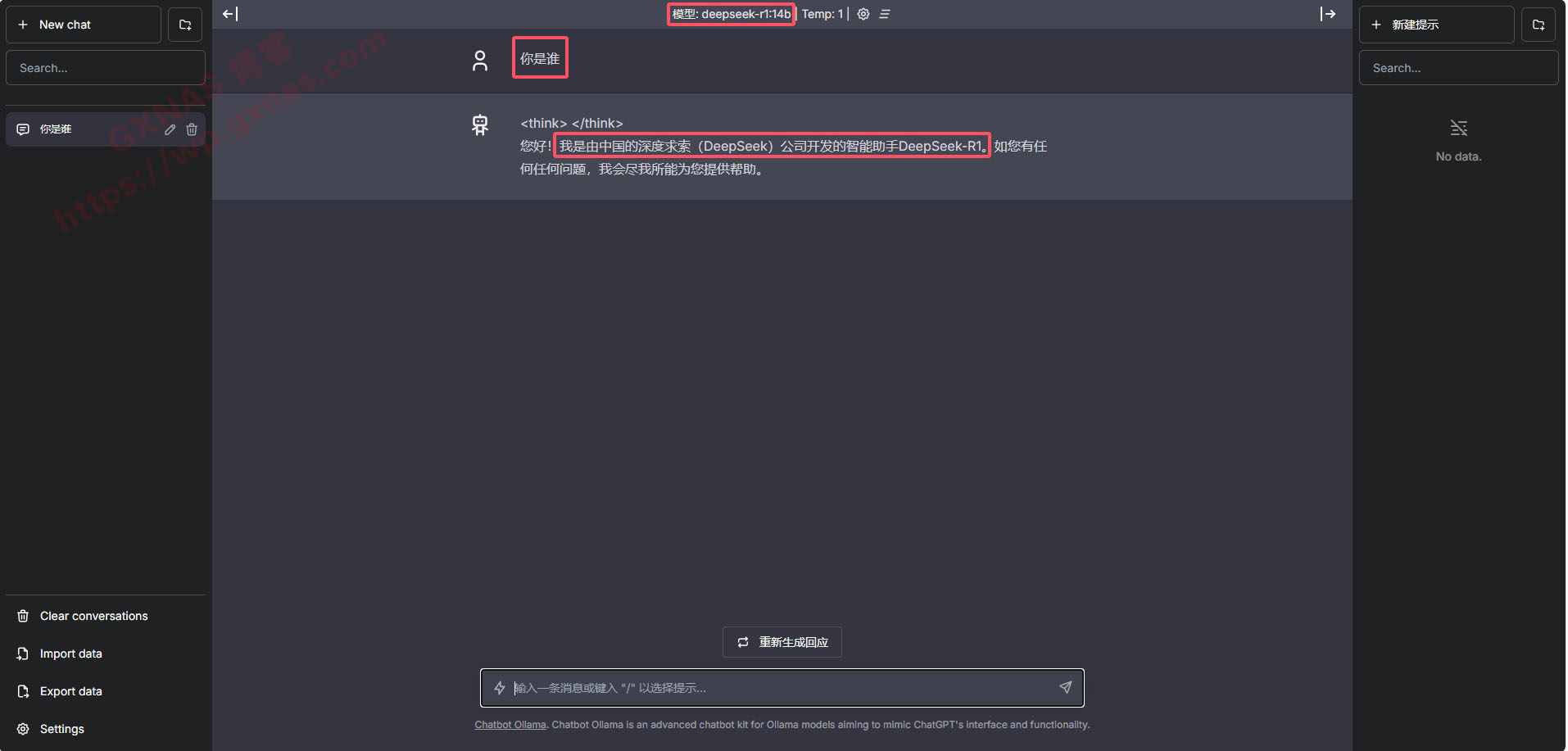

21、可以看到当前使用的DeepSeek-R1模型名称,大小;

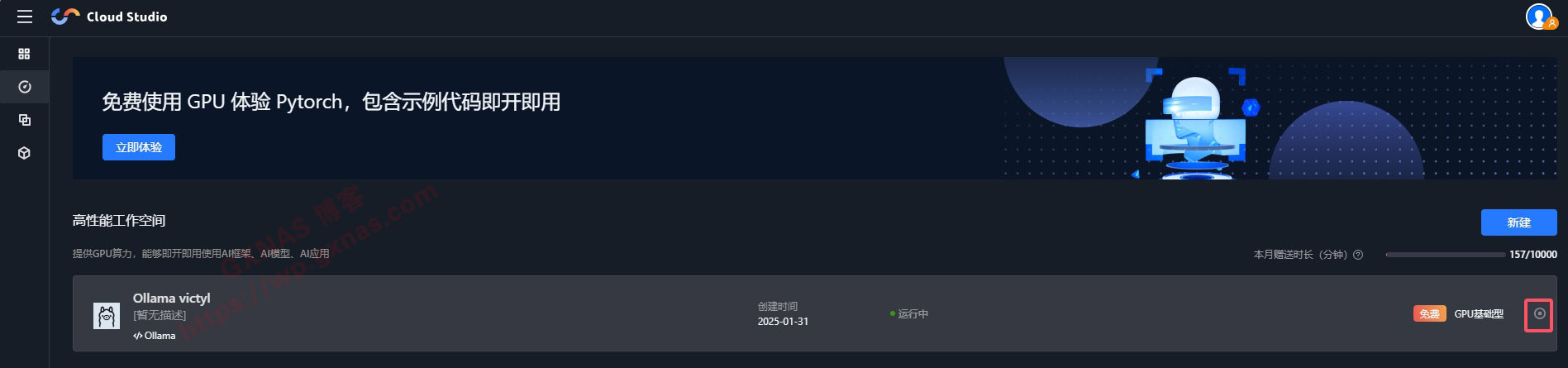

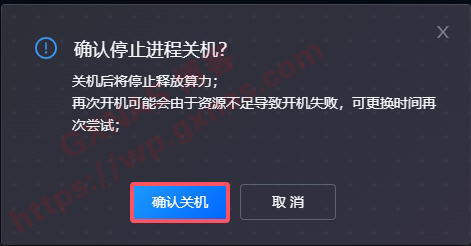

23、由于Cloud Studio提供的免费算力时间有限,当你不需要使用的时候,把Cloud Studio的终端网页关掉,同时点一下下图这个地方把服务器关机;

24、关机后不占用免费时长,需要用的时候重新开机并打开终端,就可以重新使用。

25、避坑说明:15天内硬盘在免费额度内不收费,超过15天就收费!如果就是为了白嫖的,15天内删除重建即可,只要每月使用不到10000分钟内的都是免费。

【DeepSeek-R1各版本的使用说明和硬件要求】 ❤1.5B — 针对边缘设备上的快速推理进行优化的轻量级版本。 ❤7B — 适用于通用推理任务的平衡模型。 ❤8B — 更高的准确性和更好的上下文理解。 ❤14B — 推理和解决问题的能力得到提高。 ❤32B — 更强的逻辑分析和更精细的逐步输出。 ❤70B — 适用于高级人工智能驱动应用程序的高端版本。 ❤671B — 专家混合 (MoE) 模型,每个令牌激活 370 亿个参数,以实现最先进的推理性能。

腾讯云Cloud Studio的产品说明:https://cloud.tencent.com/document/product/1039/72021

腾讯云Cloud Studio的收费说明:https://cloud.tencent.com/document/product/1039/33503

腾讯云高性能应用服务HAI的收费说明:https://cloud.tencent.com/document/product/1721/101029

文章评论

使用ngork搭建出来的界面和博主的不一样,搞半天也不能用,我的是win10系统,求解答

@Wentian 你说的不一样,那是怎样的界面。

再重启,怎么自动加载呢?

@小鱼 系统自动加载的呀。如果需要操作别的,可以重新打开终端。

知道怎么调出来了,呵呵

请问博主,如何返回到网页命令行模式?就是第10步的状态 :haha:

@Mphasis 你想用命令行的话,就新建终端啊,就是第6个步骤。

博主,请问创建模型的时候显示“已失效”,是什么问题啊?

@nanbirds 换个时间继续重新建