【前言】

大型语言模型的定义

大型语言模型(英文全称:Large Language Model,缩写LLM),也称大语言模型,是一种人工智能模型,旨在理解和生成人类语言。它们在大量的文本数据上进行训练,可以执行广泛的任务,包括文本总结、翻译、情感分析等等。LLM的特点是规模庞大,包含数十亿的参数,帮助它们学习语言数据中的复杂模式。这些模型通常基于深度学习架构,如转化器,这有助于它们在各种NLP任务上取得令人印象深刻的表现。

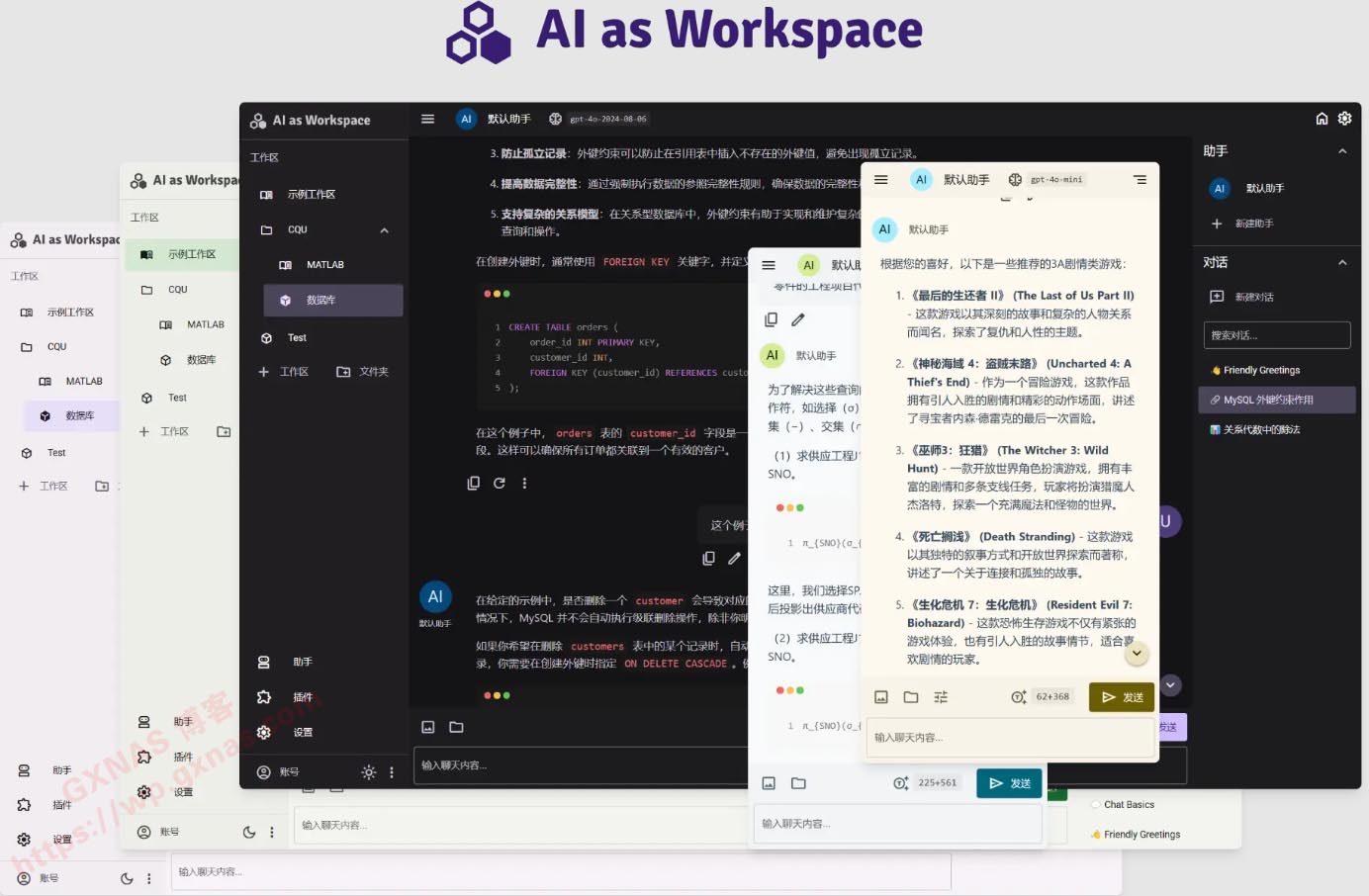

AI as Workspace的基本功能

★流式传输、上传图片、latex公式…… 这些基本的功能自然都有,无需多提

★跨平台:响应式界面设计,适配手机、电脑等不同大小和比例的屏幕

★多服务商支持:支持 OpenAI、Anthropic、Google 等不同服务商

★修改提问、重新生成 以分叉的形式实现,像 Chatgpt 官网那样(整个对话呈现“树”的结构)

★文件解析:支持上传 Word、PDF、PPT、Excel等格式文档,自动解析为文本输入

★视频解析:支持选择视频文件并指定时长范围,将自动转稿为文本输入,以此实现对视频内容的提问

★插件系统:内置了计算器、图像生成等插件。此外可在插件商店安装更多插件

★助手市场:获取各种各样定制提示词的助手(提示词来自lobe-chat-agents)

★本地优先+实时云同步:所有数据储存在本地,因此无需加载且离线可浏览。登录即可启用跨设备实时云同步

★界面主题:Material 3 设计风格;支持深色/浅色模式;支持自定义主题色

拓展使用

★多工作区:在左侧边栏,你可以创建多个工作区,将不同主题的对话、不同类型的助手分隔开;还可以创建文件夹,将多个工作区放入其中;支持嵌套

★提示词变量:除了在助手的“角色设定”中设置普通的静态提示词外,你可以通过创建提示词变量、编辑提示词模板,来构建动态且可复用的提示词

★插件拓展性:支持将任意 Gradio 应用配置为插件,同时兼容部分 LobeChat 插件;插件不仅仅提供工具调用,文件解析功能也可以通过插件拓展;工具调用支持多模态的结果

细节设计

★用户输入预览:提供正在输入的内容的实时预览;借鉴自NextChat

★代码粘贴优化:在输入框粘贴从 VSCode 复制的代码时,自动用 markdown 代码块包裹,并标明语言

★文本文件支持:支持直接添加文本类型文件(代码、csv等)到用户输入中,文件内容和文件名将作为用户输入的一部分。相比于手动将文件内容粘贴到输入框,此方法更快捷且文件内容不会占据显示空间

★粘贴:通过 Ctrl + V 粘贴,你可以粘贴文本、图片、文件;此外,在输入框之外粘贴文本时,将作为独立的文本块,像文本文件那样

★引用:用鼠标拖选对话消息内容后,点击“引用”,即可在用户输入中引用该内容。此功能相当于手动复制消息内容并粘贴到输入框中的快捷方式,方便对助手回答的部分内容针对性地追问

★快速滚动:对话右下角有快速滚动按钮,除了一般的滚动到顶部/底部,中间两个按钮是对齐到消息开头/末尾或者上一条/下一条消息的滚动,在消息较长时很方便

★键盘控制:支持设置键盘快捷键触发上述的滚动操作,以及用键盘快捷键切换消息链、重新生成、新建对话

【部署方法】

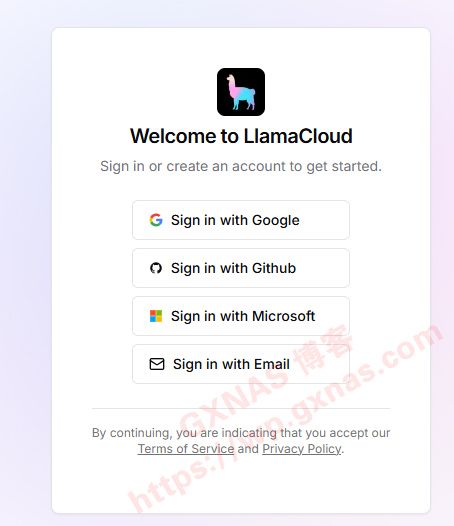

1、首先你需要有谷歌或者Github或者微软等任意一个网站的账号,点击对应的按钮登录你的账号;

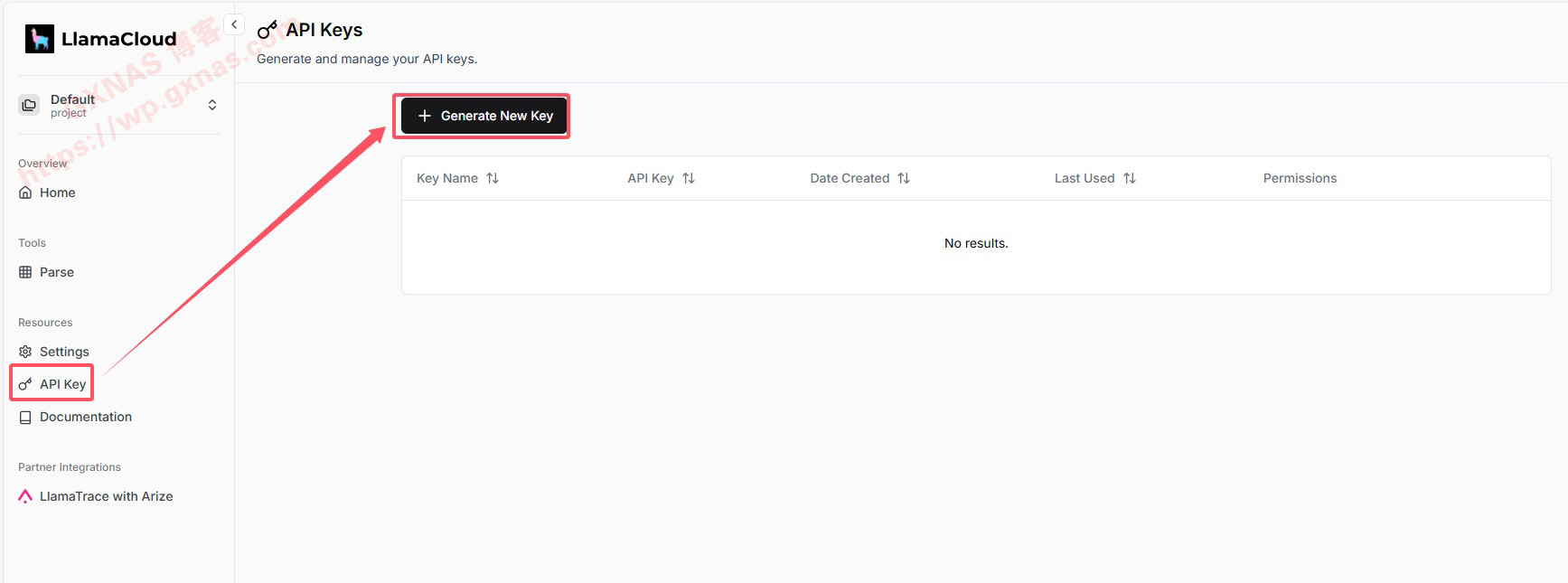

2、点左边菜单“API Key”,再点右边的“Generate New key”;

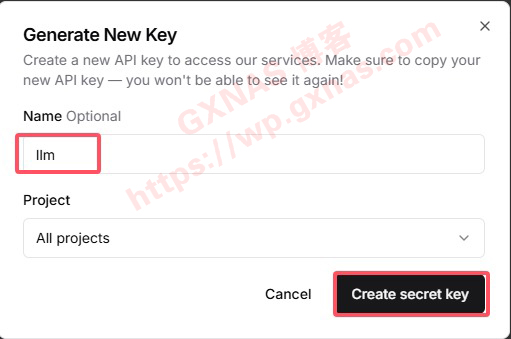

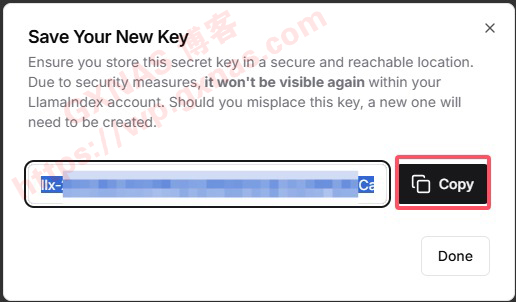

3、Name处随便填写一个名称,点“Create secret key”;

4、此时系统会生成一个key,点Copy复制出来到记事本备用;

5、打开群晖套件中心,安装Container Manager,本教程使用docker方式安装,如果想使用docker compose方式安装的话,在本教程文末复制docker compose安装脚本;

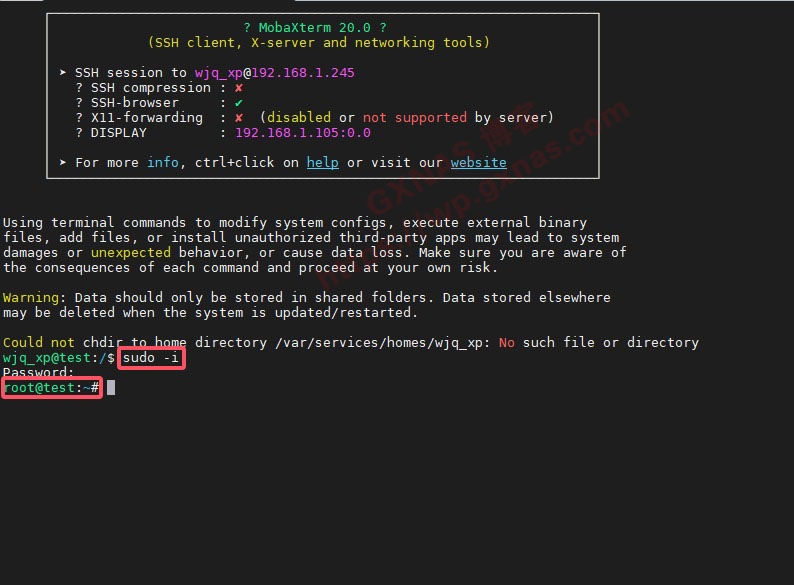

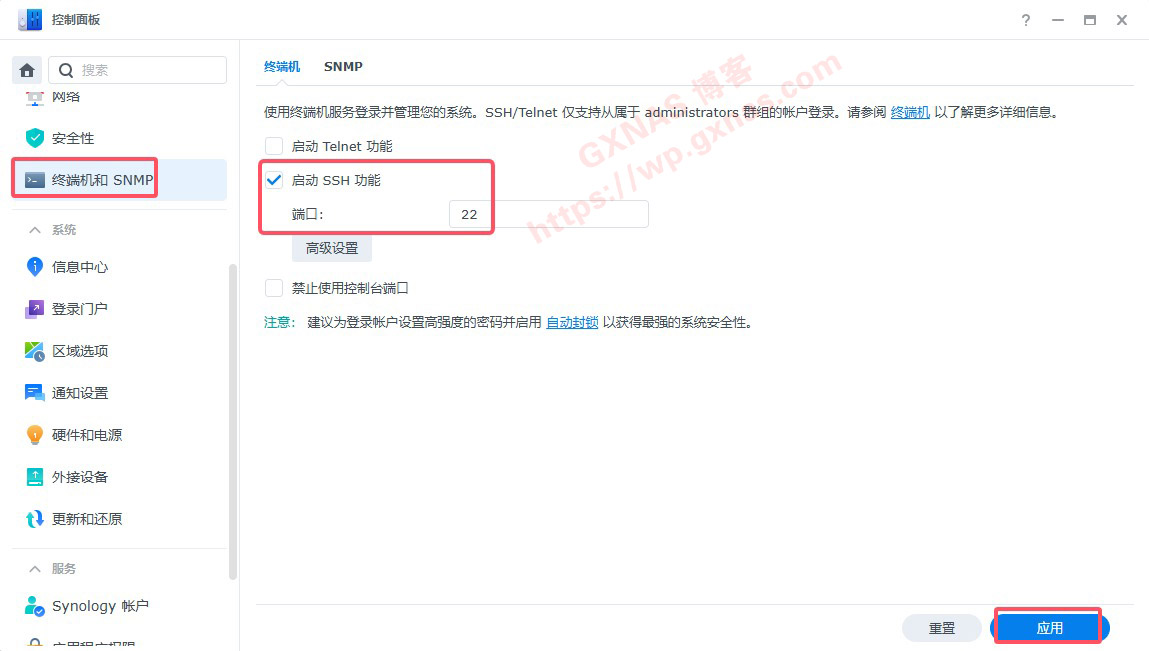

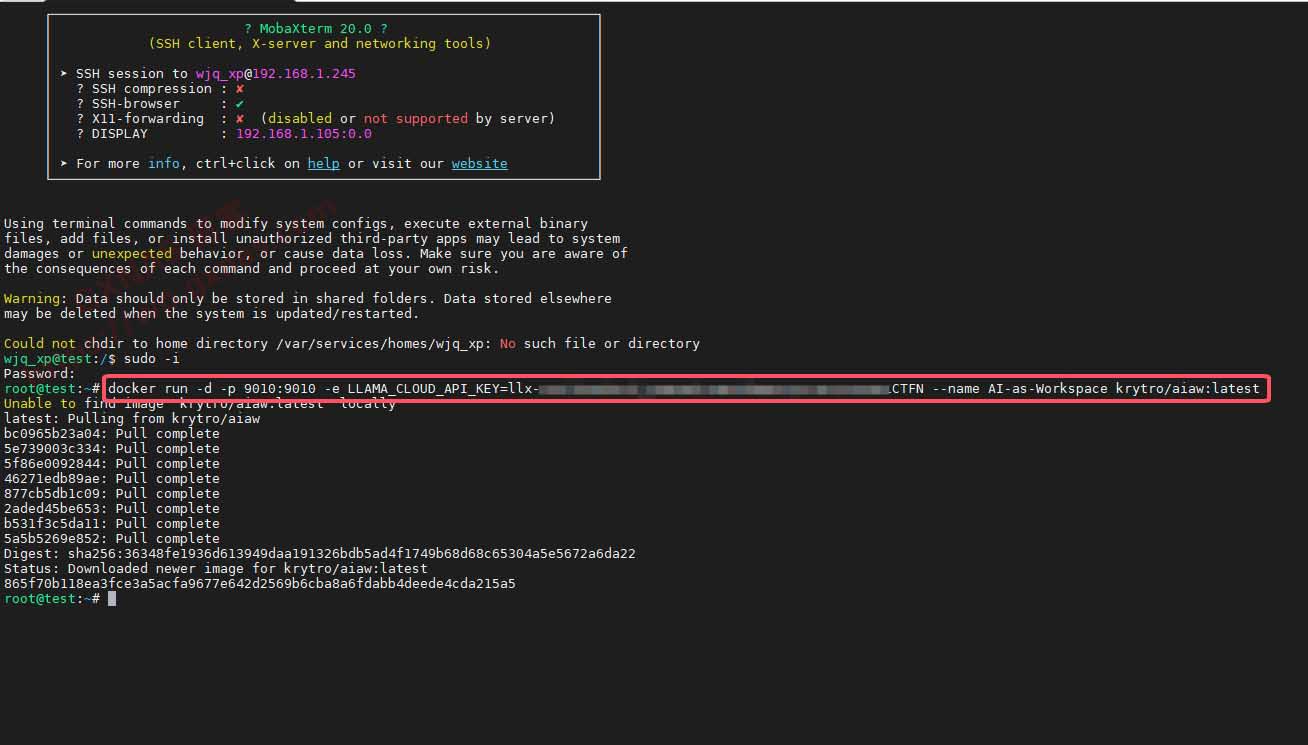

7、在电脑上打开SSH工具,输入群晖的IP地址,用户名,端口号,登录SSH;

8、输入sudo -i 回车,输入密码,进入root状态下;

9、复制以下命令,把xxxxxxx替换为第4个步骤复制出来的key,然后到ssh下运行(如果报错Error Get "https://registry-1.docker.io/v2"的,请参考《本教程》设置docker加速镜像);

docker run -d -p 9010:9010 -e LLAMA_CLOUD_API_KEY=xxxxxxx --name AI-as-Workspace krytro/aiaw:latest

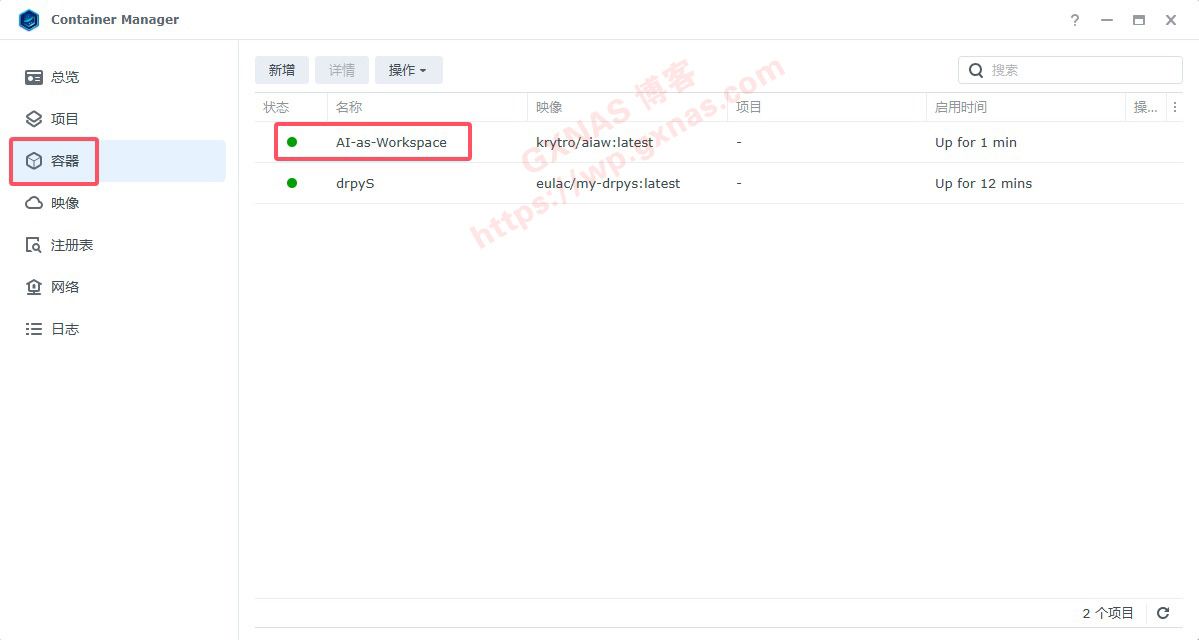

10、当看到Container Manager的容器显示有AI-as-Workspace的容器状态为绿色,就表示该容器运行正常;

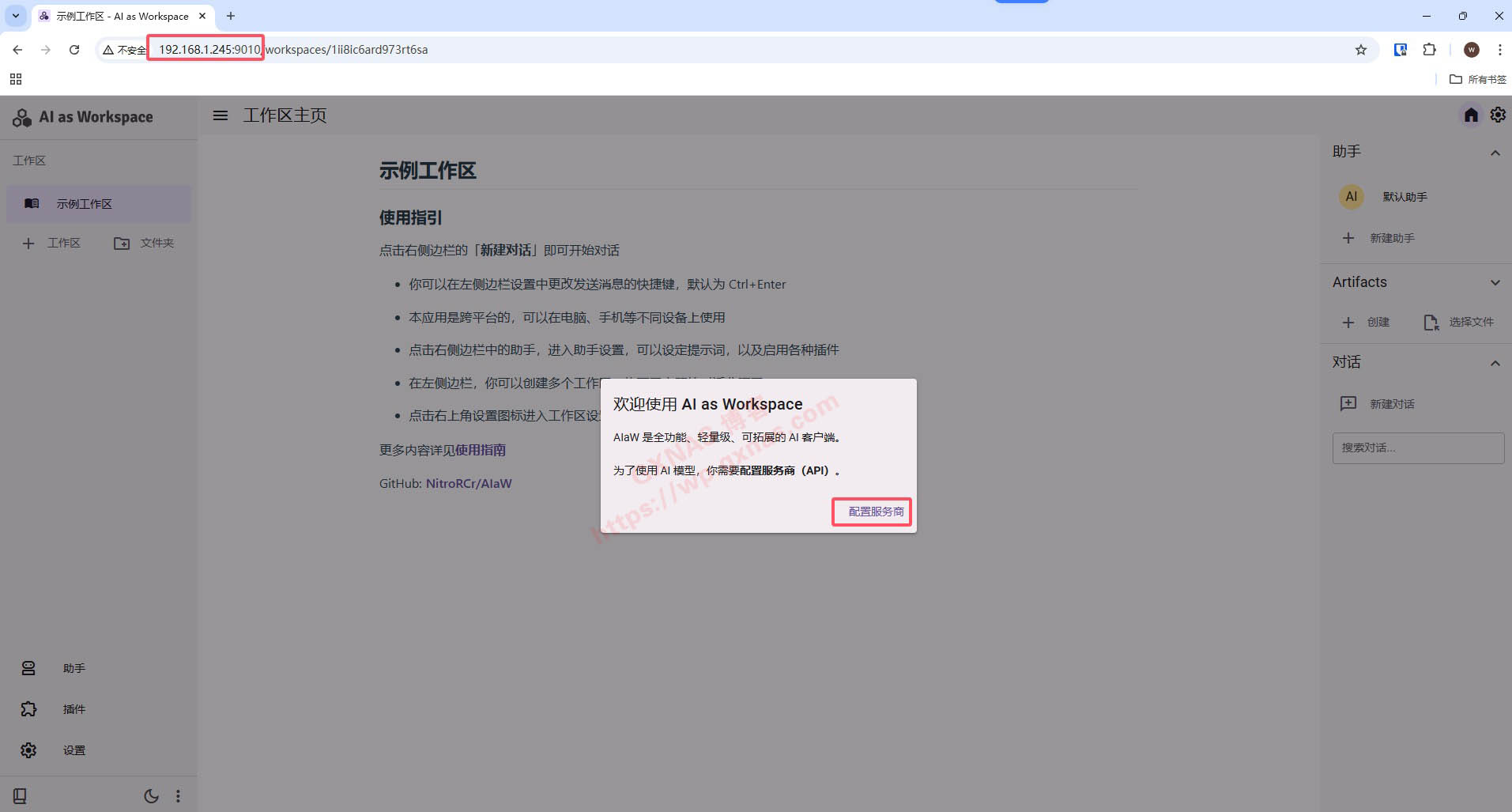

11、在浏览器打开http://群晖的IP:9010,点“配置服务商”;

12、在“自定义服务商”和“系统助手”服务商处的下拉列表中,根据自己实际情况选择对应的AI模型,并设置对应的API key;

【参考资料】

AI as Workspace的官方网站:https://aiaw.app/

AI as Workspace的官方使用文档:https://docs.aiaw.app/

AI as Workspace的docker compose安装脚本(把xxxxxxx替换为第4个步骤复制出来的key):

services:

AI-as-Workspace:

image: krytro/aiaw:latest

container_name: AI-as-Workspace

restart: unless-stopped

ports:

- '9010:9010'

environment:

LLAMA_CLOUD_API_KEY: xxxxxxx

文章评论