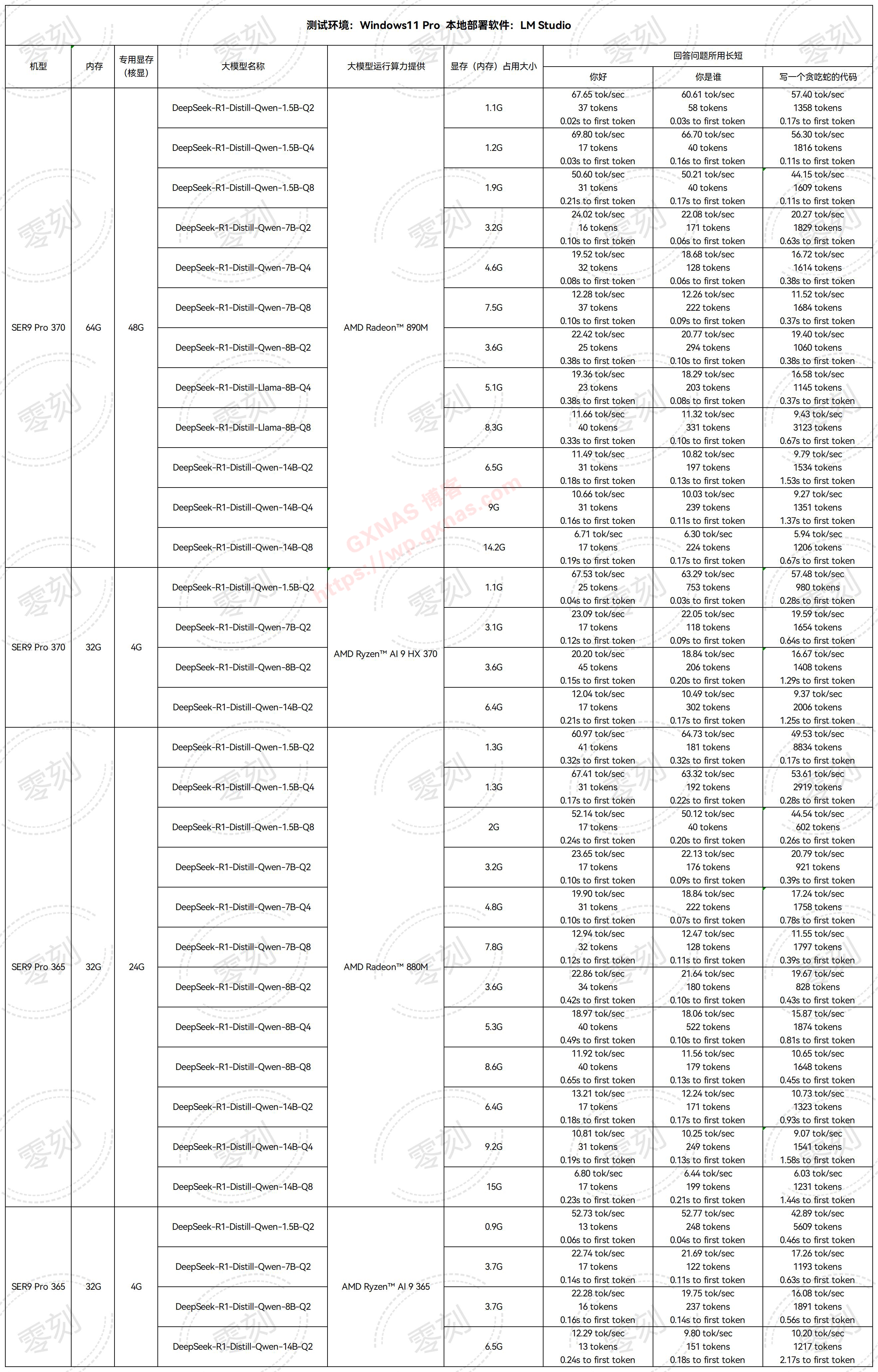

昨日,零刻科技采用LM Studio平台对SER9 Pro HX370和AI 365两款旗舰主机进行了深度评测,重点考察了DeepSeek-R1智能模型在不同参数量级与量化精度下的运算效能,旨在建立更完整的效能基准参考体系。

一、硬件评测环境:

本次实验基于SER9 Pro HX370(64GB DDR5)与AI 365(32GB DDR5)两款主机,均使用DeepSeek-R1轻量化模型架构,参数范围覆盖1.5B-14B模型,量化精度涵盖Q2-Q8精度范围。实验数据显示,两款设备在本地化模型部署方面均展现卓越适应性。特别值得注意的是,SER9 Pro在运算架构设计上实现了CPU与核显的智能协同。

二、效能对比分析:

1、图形加速模式:

- 在1.5B/7B模型运算时,SER9 Pro HX370依托其AMD RDNA3+核显架构展现出更优的能效比

- 当运行14B级模型时,双平台性能指标趋于接近,均能保持稳定的推理吞吐量

- GPU加速模式在显存利用率(VRAM Efficiency)和推理时延(Latency)方面优势显著,特别适用于实时性要求严苛的AI应用

2、中央处理器模式:

- 在纯CPU运算环境下,两款设备的基准测试结果呈现高度一致性

3、显存配置方案:

-64G内存版本支持最高48G的显存分配策略,满足14B模型GPU运算需求

-32G机型则提供24G显存优化方案,为7B以下模型提供充裕资源

这种弹性资源配置机制有效拓展了GPU加速模式对大参数量模型的支持边界。

三、部署策略建议:

1、移动端协同场景:1.5B-Q8模型仅需8G显存即可流畅运行,特别适配边缘计算需求

2、日常办公场景:推荐选用8B版本,其在1.3TFLOPS运算效能与12GB显存占用之间达成最佳平衡

3、专业创作场景:对于需要处理多模态数据的复杂场景,建议启用14B高精度模型,其3.8TFLOPS的峰值算力可充分满足NLP高阶任务需求

注:本评测采用动态温度墙管理策略,所有测试数据均在设备温度阈限范围内测得。

值得关注的是,SER9 Pro HX370通过动态功耗调节技术,在持续运行14B模型时仍能将整机功耗控制在45W以内,为紧凑型主机的大模型部署树立了新能效标杆。此次测试不仅验证了消费级硬件本地化AI部署的可行性,更为中小企业构建私有化智能系统提供了精准选型参考。

文章评论